浅谈信任

不得不说,信任是十分珍贵且稀少的一样东西。其珍贵和稀少的原因很简单——怀疑是很容易的。

This is an automatically translated post by LLM. The original post is in Chinese. If you find any translation errors, please leave a comment to help me improve the translation. Thanks!

It has to be said that trust is something extremely precious and rare. The reason for its preciousness and rarity is simple - doubt is easy.

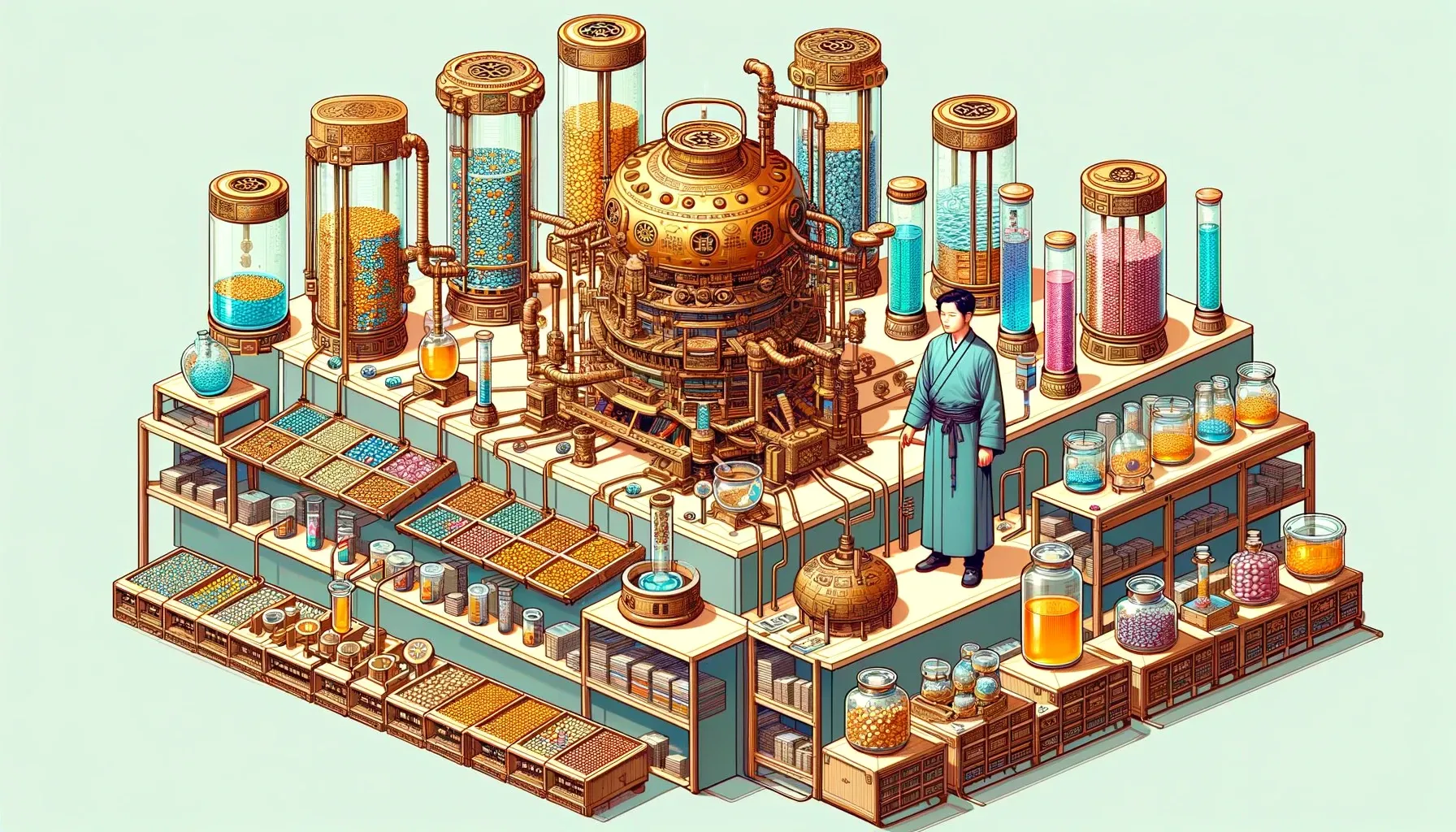

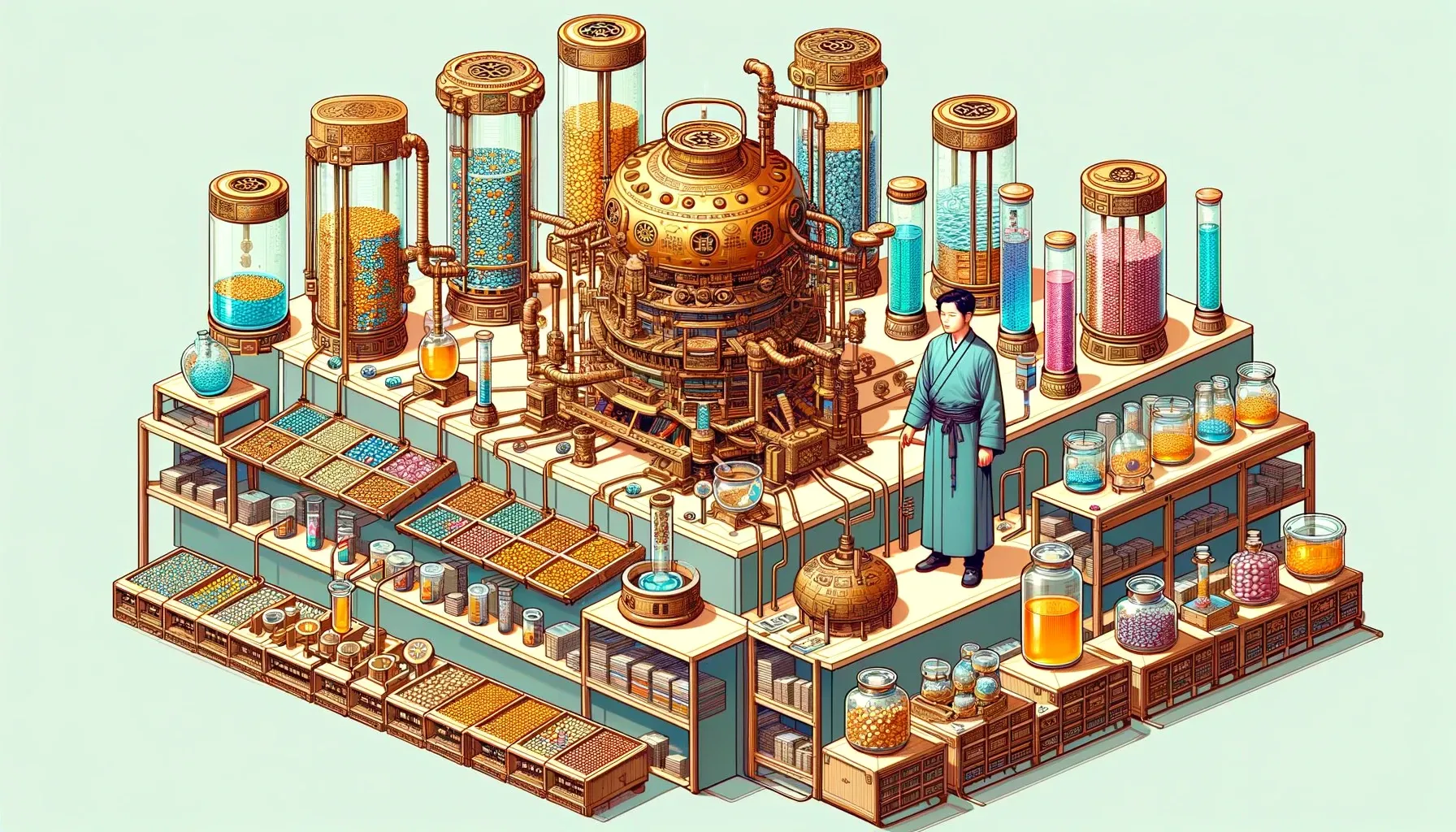

丹药管理是炼丹术中很重要的部分。毕竟,当一批一批的丹药通过不同的材料和火候炼制出来之后,我们总是会产生如下需求:

为了实现以上需求,我们便需要炼丹管理技术,简单来说,就是要在

代码,超参数,模型之间建立映射关系并对齐进行存储,以便支持后续的分析以及训练过程的回溯。由此,诞生了很多机器学习全生命周期管理软件,本文主要介绍一款开源软件:MLflow

的简单使用流程

This is an automatically translated post by LLM. The original post is in Chinese. If you find any translation errors, please leave a comment to help me improve the translation. Thanks!

Dan medicine management is a crucial part of alchemy. After all, when batches of pills are produced through different materials and firing processes, we always have the following needs:

To meet these needs, we need alchemy management technology. In simple

terms, we need to establish mappings and alignments between

code, hyperparameters, and models

for storage, in order to support subsequent analysis and training

process tracing. As a result, many machine learning lifecycle management

software have been developed. This article mainly introduces an

open-source software called MLflow and its simple usage

process.

前段时间,我完成了第一篇论文,经历了从选题 -> 实验 -> 结果分析 -> 论文的全过程。在此期间虽然走了一些弯路,但也对科研发文的方法论有了新的认识。本文将围绕该次发文过程,概述科研大体流程,并对其中的一些细节进行思考。为今后的科研发文以及想要发文章的朋友们提供参考。

致谢:感谢在实验和论文撰写过程中给予我指导的老师以及与我探讨的朋友们。

This is an automatically translated post by LLM. The original post is in Chinese. If you find any translation errors, please leave a comment to help me improve the translation. Thanks!

Recently, I completed my first research paper, going through the entire process from topic selection to experiments, result analysis, and paper writing. Although I took some detours along the way, I gained new insights into the methodology of scientific research and writing. This article will outline the general process of scientific research and discuss some of the details, providing reference for future research and for those who want to publish articles.

Acknowledgments: Thanks to the teachers who guided me during the experiments and paper writing, as well as friends who discussed with me.

This is an automatically translated post by LLM. The original post is in Chinese. If you find any translation errors, please leave a comment to help me improve the translation. Thanks!

This article mainly reviews and summarizes reinforcement learning algorithms based on policy optimization theorems and related variants.

深度学习的实验通常都需要跑很久,如果没有主动推送的手段,那么就会出现以下两种情况:

为解决以上问题,就需要给实验程序加上监控进程,在实验结束后进行通知并发送实验结果。本文的脚本主要包含三部分内容:进程监控,tensorboard 数据提取,企业微信机器人通知。

This is an automatically translated post by LLM. The original post is in Chinese. If you find any translation errors, please leave a comment to help me improve the translation. Thanks!

Deep learning experiments usually take a long time to run. Without proactive notification, two situations may arise:

To solve the above problems, it is necessary to add a monitoring process to the experimental program, notify and send the experimental results after the experiment ends. This article's script mainly includes three parts: process monitoring, tensorboard data extraction, and enterprise WeChat robot notification.